반응형

13.3 셀프 어텐션(Self-attention)과 트랜스포머

13.3.1 셀프 어텐션의 이해

- 셀프 어텐션의 목적은 문장 내에서 단어 간 영향을 표현하는 것

- 어떤 단어를 벡터로 임베딩할 때, 그 단어에 영향을 미치는 다른 단어들의 정보를 함께 인코딩하고 싶은 것

- 각 단어들에 대해 그 단어에 영향을 미치는 단어들의 정보를 선별해 자신에게 축적

- 이 경우 각 단어가 모두 자신에게 오는 어텐션에 대한 정보를 갖고 있으므로 RNN 혹은 LSTM에 기반한 seq2seq 모형과는 달리 어느 한 벡터가 전체 문맥에 대한 정보를 축적하고 있지는 않음

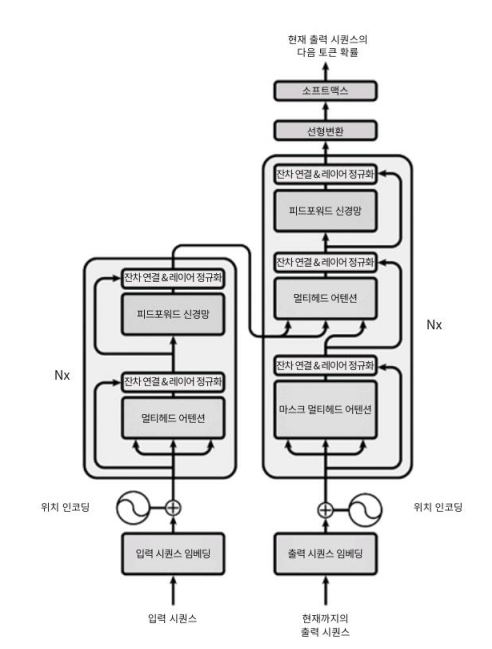

13.3.2 트랜스포머의 구조

- 현재 딥러닝을 이용한 자연어 처리 모형의 정점

- BERT(Bidirectional Encoder Representations from Transformers)

- 트랜스포머는 번역을 위해 개발된 모형

- 영어를 독일어와 프랑스어로 번역한 결과를 성능의 기준으로 삼음

- 인코더 층 구조

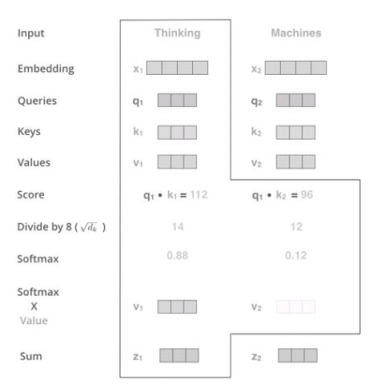

13.3.3 인코더의 셀프 어텐션 원리

- query, key, value 세개의 벡터를 이용해서 계산

- query: 어텐션을 받는 단어가 어텐션과 관련해 다른 단어들에게 던지는 질문

- key: 그에 대한 대답

13.3.4 디코더의 작동 원리

- 디코더에는 인코더에서 디코더로 향하는 멀티헤드 어텐션 층이 하나 더 있음

- 디코더의 셀프 어텐션 층은 인코더와 달라 Masked가 추가되어 있음

※ 해당 내용은 <파이썬 텍스트 마이닝 완벽 가이드>의 내용을 토대로 학습하며 정리한 내용입니다.

반응형

'텍스트 마이닝' 카테고리의 다른 글

| BERT의 이해와 간단한 활용 (2) (0) | 2023.08.01 |

|---|---|

| BERT의 이해와 간단한 활용 (1) (0) | 2023.07.31 |

| 어텐션(Attention)과 트랜스포머 (1) (0) | 2023.07.29 |

| CNN - 이미지 분류를 응용한 문서 분류 (1) (0) | 2023.07.28 |

| Word2Vec, ELMo, Doc2Vec의 이해 (2) (0) | 2023.07.27 |