반응형

13.1 Seq2seq: 번역에서 시작한 딥러닝 기법

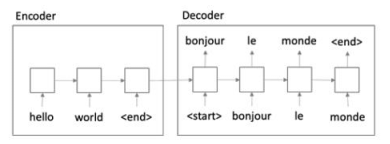

- seq2seq: 일련의 단어들이 들어오고 이를 이용해서 다시 일련의 단어들을 생성해야 하는 문제

- seq2seq 문제에 적용할 수 있는 가장 단순한 딥러닝 모형은 RNN

- 모형은 인코더와 디코더로 이루어짐

13.2 어텐션을 이용한 성능의 향상

- 컨텍스트 벡터: 추가된 부분의 인코더 윗부분, 예측에 가장 많은 영향을 미치는 단어에 대한 정보가 담겨 있음

- 어텐션 메커니즘은 번역의 성능을 향상시킨 결정적인 발견 중 하나

※ 해당 내용은 <파이썬 텍스트 마이닝 완벽 가이드>의 내용을 토대로 학습하며 정리한 내용입니다.

반응형

'텍스트 마이닝' 카테고리의 다른 글

| BERT의 이해와 간단한 활용 (1) (0) | 2023.07.31 |

|---|---|

| 어텐션(Attention)과 트랜스포머 (2) (0) | 2023.07.30 |

| CNN - 이미지 분류를 응용한 문서 분류 (1) (0) | 2023.07.28 |

| Word2Vec, ELMo, Doc2Vec의 이해 (2) (0) | 2023.07.27 |

| Word2Vec, ELMo, Doc2Vec의 이해 (1) (0) | 2023.07.26 |